解决AI偏见:设计多样性

在人力资源的众多主题中,多样性经常受到关注。然而,高级分析或人工智能解决方案应用于多样性的情况并不多见,尤其是与人员流失率和缺勤率等主题相比。当然,给性别、种族等数字是很棘手的:反歧视的见解也可能被用来歧视。因此,多样性不像我们习惯的那样需要正面的方法。在本文中,我将探讨如何在模型开发中实现设计的多样性。

多样性和人工智能:一个难以忽视的事实

谈到多样性,许多干预措施似乎都是为了解决症状和提高认识。这已经可以带来急需的积极变化。

不过,提高多样性往往是泛泛而论的。虽然分析可以为更有针对性的行动提供新的见解,但所需的数据往往处于隐私和道德的禁区。分析和多样性似乎不能共存。

然而,当它们混合在一起时,分析实际上可以对多样性产生深远的影响。事实上,当看看媒体报道的这些对性别多样性的影响时,情况看起来并不乐观:

一种经常听到的解释是,模型加强甚至放大了开发人员无意识的偏见。虽然我认为这是一个过于强烈的声明,但人工智能最终确实会因为设计中的人为错误而维持多样性问题。(这些设计缺陷早在人工智能兴起之前就已经无处不在了:想想看汽车安全和办公室温度例如。)针对这类问题,一个经常被提出的流行解决方案是增加分析团队的多样性:当然,女性会发现上面例子中的缺陷!

事实上,他们可能已经做到了,我完全支持在分析团队中增加多样性和观点。然而,增加多样性并不是无偏见人工智能的完美解决方案。如果是的话,我们可以说“这个模型是在一个多样化的团队中设计的,因此是没有偏见的。”你会毫不犹豫地接受吗?

相关(免费)资源!继续往下读↓

学会指挥

D&I调查

下载我们的免费指南,了解如何收集所需数据,以帮助您的组织变得更具包容性

我们在处理人为错误,我们都有自己的偏见和盲点。采用多样化的团队并不能完全解决模型存在偏差的问题。虽然不同的观点和同行评议会提高工作质量,但要记住,由一个完整的委员会进行的分析(以消除任何潜在的偏见)将是缓慢的,甚至是无效的。

理解问题

那么,谈到多样性,我们应该放弃分析吗?我不这么想。我也不认为答案仅仅在于要求开发人员更仔细地考虑数据选择。我认为我们应该讨论如何获得和评估模型性能。

前面提到的例子是针对最初与多样性议程无关的任务开发的。在开发过程中没有考虑到多样性是可以理解的,但由此产生的模型实际上似乎倾向于减少性别多样性并保持刻板印象。为了解决这个问题,我们首先需要了解模型是如何达到这些结果的。

机器学习模型是基于数据的模式。历史数据。这些数据倾向于代表一个组织的当前状态和几年前的情况。从这个时间框架来看,许多组织发现,性别多样性(例如关键职位)可能会更好。为了讨论的方便,让我们假设担任关键职位的人一般都是男性。

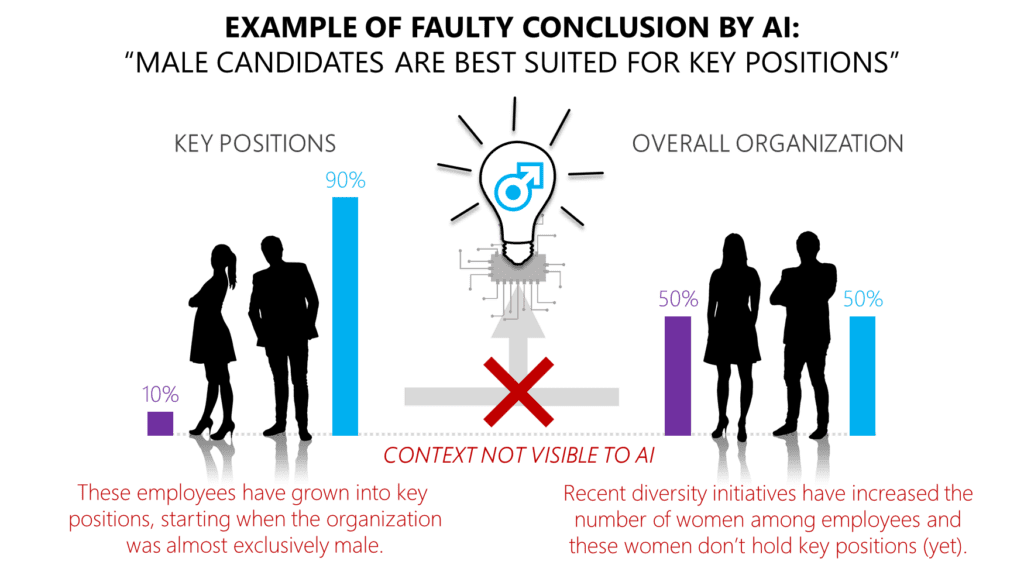

图1 -人工智能错误结论的例子

目前的关键职位的负责人来自于一个比今天更以男性为主导的组织。为了增加多样性,近年来招聘了更多女性。正因为如此,目前在关键职位上的男性比例明显高于目前在组织中男性的总体比例。该算法(或人工智能)利用那些担任关键职位的人和那些没有担任关键职位的人之间的差异来预测适合担任关键职位,因此错误地得出性别是一个区别特征的结论。(否则,关键职位的男女比例将与整个组织的情况一样,是50/50。)

算法不知道上下文,只看表面值。因此,改善多样性的干预措施甚至可能导致人工智能的偏见,这与你的议程背道而驰。在图1的例子中,招聘女性在关键职位和其他员工之间造成了显著的性别分布差异,这实际上做出了贡献在判断关键职位的候选人时,模型中出现了不必要的偏差。

当然,允许性别作为模型使用的一个特征是不明智的,但要对抗人工智能的性别偏见并没有简单的解决办法。即使你不包括性别,算法也可以识别出性别之间的其他差异,比如兼职工作或在简历上参加过姐妹会。

解决问题

在批评带有不必要甚至不道德偏见的模型时,人们倾向于关注数据选择。当然:数据选择是至关重要的。但我们也需要问自己,我们是否在正确的目标条件下训练我们的模型。专注于模型开发的这一方面,可以将其形式化为技术解决方案,并具有以下好处:

- 标准化,因为它可以在整个组织中实现一般的模型开发(不仅仅是针对HR)。

- 透明度关于模型对多样性目标(以及潜在的其他目标)的影响,因为模型在开发过程中明确地针对这些目标进行评分

一般来说,我们对模型的唯一要求是基于所选特征准确匹配历史结果。我们含蓄地告诉AI,目的(即匹配示例结果)证明了手段(即使用哪些特征)是正确的,我们的历史(即使用的数据)代表了我们未来的目标。这在严格的数学环境中很有效,在这种环境中,假设上下文是恒定的,理想和伦理最好保持在方程之外。

现实世界的问题往往会引入额外的复杂因素。通往解决方案的最短路径可能不是最好的,我们需要意识到人工智能是根据“最佳”的定义来选择路径的我们提供的。在开发AI时,最短路径通常是算法的最佳结果,因为我们没有完全指定目标条件是什么。我们需要显式地提供它。

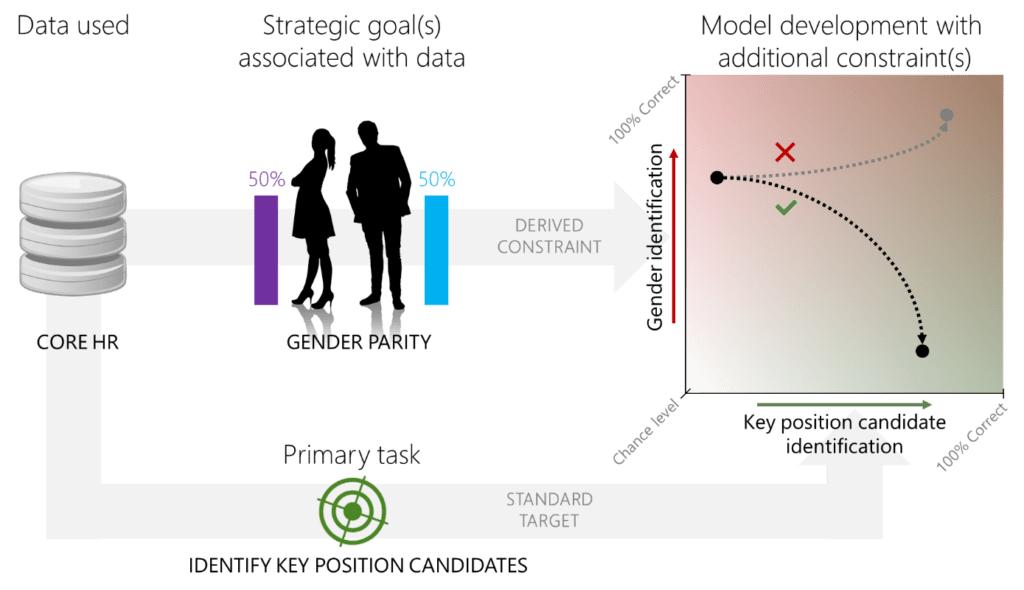

考虑一个预测候选人是否适合一个关键职位的例子:我们希望模型的目标是在可用的(历史)数据上很好地预测这一点,但要使用使性别和被认为适合关键职位之间的相关性尽可能接近于0的特征来做到这一点。换句话说:我们希望关键职位人员的识别很好,但是使用相同的特征来识别性别应该很糟糕。因为我们知道模型使用员工数据,所以我们将这个约束添加到模型开发中。这一限制源于员工性别平等的战略目标,并为那些对员工数据进行分析的人正规化。

图2 -更明确地指示AI

该组织的战略目标之一是性别平等。手头任务(关键职位候选人的识别)的主要数据源与这一目标相关。使用这些数据的模型的派生约束是,它们在识别性别方面的表现应该最小化。通常,模型只需要最大化给定任务的性能(下面的箭头,水平轴)。该组织选择了一种易于实施的方法,以尽量减少性别差异的可能性。当模型被指示寻找识别关键职位候选人的最佳性能时,使用相同数据的模型副本将根据性别识别进行检查,这应该尽可能接近机会水平(纵轴)。

这会让事情变得复杂吗?肯定。它能保证消除性别偏见吗?不幸的是,并不是这样,但是在模型投入生产之前,它强制执行了模型估计的性别偏见的指示。不仅如此,它还明确指示算法在数据中找到最能告诉我们关键职位持有者的特征,但最不能告诉我们性别的特征:设计多样性。最重要的是,它降低了只有在模型发布后才发现对多样性的不利影响的风险。

结论

一个机器学习算法,或者你更喜欢的人工智能应用程序,不会为我们的理想或道德考虑而烦恼。人工智能还没到那一步。我们需要意识到这种上下文知识的缺乏,并相应地指导模型。这对于多样性尤其重要,因为我们所追求的场景往往与我们以人工智能为例来模仿的历史不同。

最常听到的解决方案是更加谨慎地选择数据。这将留给开发人员很多考虑,并为标准化和透明度提供有限的机会。它也不能保证事先表明对已知组织目标(如性别平等)的不利影响。

我认为,答案已经摆在我们面前有一段时间了。我们需要设计的多样性,我们可以通过谨慎选择数据和更具体地设定模型性能目标来实现。为了标准化和实现它,我们需要:

- 确定战略人员的目标以及数据,如果使用数字解决方案,这些目标可能会受到影响;

- 根据使用的数据形式化模型开发的约束,并在工具和工作方式中实现这些约束。

看看上面的两点,很快就会发现,这不仅仅与开发人员有关。管理、数据所有者、IT和分析专业人员(可能还有更多)都需要确保我们为更负责任的模型部署正式化和实现正确的额外检查和平衡。

对其他公司的失误摇头并指责开发者,不会让我们找到一个成熟的解决AI偏见的方案。让我们把这看作是行动的号召,团结起来!

你准备好迎接HR的未来了吗?

在线学习现代和相关的人力资源技能